17 Oct L’inférence en Intelligence Artificielle : Au-delà des solutions

Ces derniers mois, Wattdesign et ses clients ont vu augmenter le nombre de projets pour le déploiement d’applications d’intelligence artificielle. Nos jumeaux numériques de data centers modélisent les futures baies accueillant des serveurs pour l’IA. Ils sont essentiels pour étudier leur refroidissement. Et cela relève souvent du challenge thermique étant donné les puissances dissipées ! Nous vous présenterons des exemples à l’occasion de Data Center World Paris (15-16 Novembre), sur notre stand et lors de la table ronde le 16 Novembre 2023. Mais en attendant, prenons un peu de recul et analysons le nouveau vocabulaire qui fleurit avec l’IA. Par exemple, l’inférence.

Dans le monde en constante évolution de l’intelligence artificielle (IA), l’inférence occupe une place cruciale et souvent sous-estimée. L’inférence est bien plus qu’une simple étape dans leurs cycles de vie. Il s’agit d’un processus qui permet aux modèles d’IA de transformer les données en informations utiles pour prendre des décisions éclairées. Regardons ici ce qu’est l’inférence, son rôle crucial et ses implications pour l’avenir de cette technologie émergente.

L’inférence en Intelligence Artificielle : Un aperçu

L’inférence en IA est le processus par lequel un modèle d’apprentissage automatique, préalablement entraîné, est utilisé pour effectuer des prédictions ou des classifications sur de nouvelles données en temps réel. Contrairement à la phase d’entraînement, où le modèle apprend à partir d’un ensemble de données, l’inférence est l’étape où le modèle utilise les connaissances qu’il a acquis pour résoudre des problèmes réels.

Imaginez un modèle d’IA conçu pour effectuer de la reconnaissance d’objets dans des images. Lors de la phase d’entraînement, il a appris à distinguer des milliers d’objets différents à partir de nombreuses images. Cependant, lorsqu’il est déployé dans le monde réel, il doit être capable de reconnaître ces objets en temps réel. Que ce soit dans des photos, des vidéos ou des flux de données.

L’inférence en pratique

Maintenant que nous comprenons ce qu’est l’inférence, examinons quelques-unes de ses applications concrètes dans notre vie quotidienne. Vous avez probablement déjà interagi avec des systèmes d’inférence en utilisant des assistants vocaux comme Siri. Vous avez utilisé des filtres d’applications de médias sociaux qui reconnaissent votre visage ou même des systèmes de détection de fraude qui protègent vos transactions financières.

L’inférence alimente ces applications et bien d’autres encore, en permettant aux machines de comprendre, de prédire et de réagir en fonction des données entrantes. Cela ouvre la voie à des avancées passionnantes, de la médecine à l’industrie automobile, en passant par la finance et la robotique.

Comment tout cela se traduit dans nos jumeaux numériques ? Ce sont de nouveaux équipements spécifiques pour l’inférence qui apparaissent dans nos répliques virtuelles de data centers. En effet, des constructeurs comme NVIDIA proposent des solutions dédiées à l’inférence. Les systèmes GPU NVIDIA H100, A100, A30 et A2 Tensor Core fournissent des performances d’inférence élevées pour le Cloud, les Data Centers et les systèmes Edge. HPE quant à lui propose des solutions pour maximiser la puissance d’inférence avec le HPE ProLiant DL380 Gen10 Plus associé aux GPU NVIDIA A30. IBM n’est pas en reste avec sa plate-forme Power10.

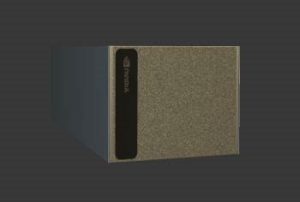

Baie avec deux NVIDIA DGX H100

Nos équipes sont donc à pied d’œuvre pour créer les éléments de bibliothèque de notre solution Cadence Design Insight Platform (ex 6SigmaDCX). Nous avons donc désormais les derniers serveurs d’inférence pour nos utilisateurs travaillant sur des projets de déploiement de baies pour l’IA. Des dizaines de nouveaux éléments en bibliothèque rejoignent les milliers déjà présents. Ils sont essentiels pour modéliser finement les phénomènes aérauliques complexes générés par ces équipements. Ils font la force de notre solution.

Modèle en bibliothèque de Cadence DataCenter Insight Platform

Au-delà des solutions

Il est crucial de reconnaître que, bien que l’inférence soit un élément clé dans le développement de l’IA, elle est également au cœur de la transformation de notre société. Elle soulève des questions importantes concernant la protection de la vie privée, l’éthique, la réglementation et bien d’autres domaines.

L’inférence en IA ne se limite pas à des applications commerciales ou technologiques. Elle s’étend également à des domaines cruciaux tels que la médecine. Elle peut par exemple aider à diagnostiquer des maladies plus rapidement et avec une précision accrue. Cependant, cela soulève des questions sur la confidentialité des données médicales et la responsabilité éthique de l’utilisation de l’IA dans ce contexte.

De plus, l’inférence en IA peut jouer un rôle majeur dans la résolution de problèmes mondiaux, tels que le changement climatique, en analysant des ensembles de données massifs pour trouver des solutions durables. Cette technologie esquisse donc une nécessité de collaboration étroite entre les chercheurs en IA, les gouvernements et les organisations internationales.

En conclusion, l’inférence en intelligence artificielle est bien plus qu’une simple étape technique. C’est une clé qui ouvre la porte à un avenir où les machines peuvent comprendre et réagir au monde qui les entoure. Alors que nous continuons à avancer dans ce domaine passionnant, n’oublions pas de réfléchir aux implications éthiques et sociétales de nos actions.

Nous pourrons débattre du sujet lors de la table ronde de Data Center World Paris dans quelques semaines.